推荐:使用NSDT场景编辑器助你快速搭建3D应用场景

|

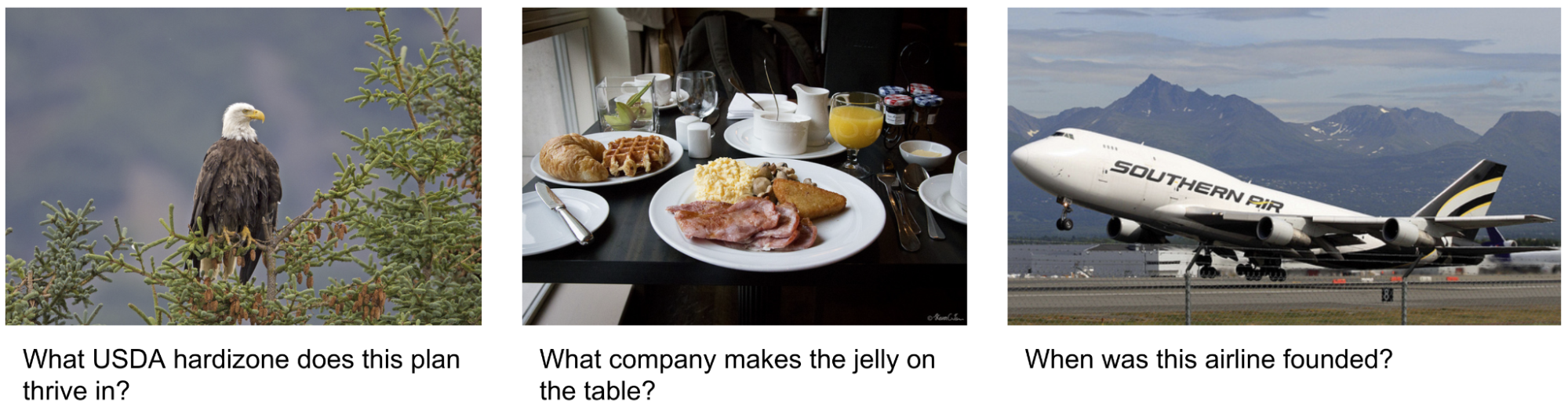

| 视觉信息寻求查询的示例,其中需要外部知识来回答问题。图像取自 OK-VQA 数据集。 |

在”AVIS:使用大型语言模型的自主视觉信息搜索“,我们介绍了一种新颖的方法,该方法可以在视觉信息搜索任务上实现最先进的结果。我们的方法将LLM与三种类型的工具集成在一起:(i)用于从图像中提取视觉信息的计算机视觉工具,(ii)用于检索开放世界知识和事实的网络搜索工具,以及(iii)图像搜索工具,用于从与视觉相似的图像相关的元数据中收集相关信息。AVIS聘请了LLM驱动的规划师,在每一步选择工具和查询。它还使用 LLM 驱动的推理器来分析工具输出并提取关键信息。工作记忆组件在整个过程中保留信息。

|

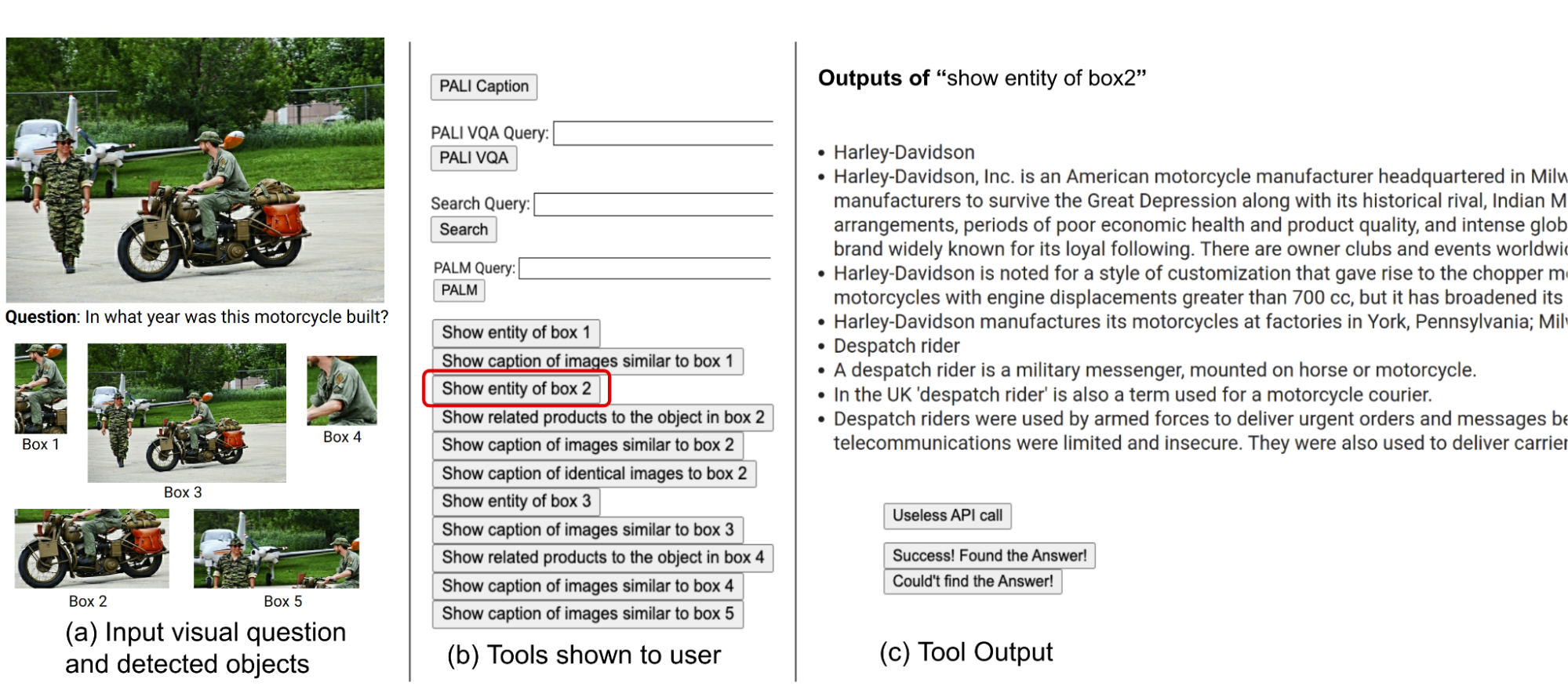

| AVIS生成的工作流程示例,用于回答具有挑战性的视觉信息搜索问题。输入图像取自信息查找数据集。 |

与以前工作的比较

近期研究(例如,Chameleon, ViperGPT和MM-ReAct)探索向LLM增加多模式输入工具。这些系统遵循两个阶段的过程:计划(将问题分解为结构化程序或指令)和执行(使用工具收集信息)。尽管在基本任务上取得了成功,但这种方法在复杂的现实场景中经常会步履蹒跚。

对将LLM作为自主代理应用的兴趣也激增(例如,WebGPT和ReAct).这些代理与其环境交互,根据实时反馈进行调整,并实现目标。但是,这些方法不会限制在每个阶段可以调用的工具,从而导致巨大的搜索空间。因此,即使是当今最先进的LLM也可能陷入无限循环或传播错误。AVIS通过引导LLM使用来解决这个问题,受到用户研究中人类决策的影响。

通过用户研究为LLM决策提供信息

数据集中的许多视觉问题,例如信息搜索和OK-VQA即使对人类来说也构成了挑战,通常需要各种工具和API的帮助。下面显示了来自 OK-VQA 数据集的示例问题。我们进行了一项用户研究,以了解使用外部工具时的人类决策。

|

| 我们进行了一项用户研究,以了解使用外部工具时的人类决策。图像取自 OK-VQA 数据集。 |

用户配备了与我们的方法相同的工具集,包括巴利语,手掌和网络搜索.他们收到输入图像、问题、检测到的对象裁剪以及与图像搜索结果相关的按钮。这些按钮提供有关检测到的对象裁剪的各种信息,例如知识图谱实体、相似图像标题、相关产品标题和相同的图像标题。

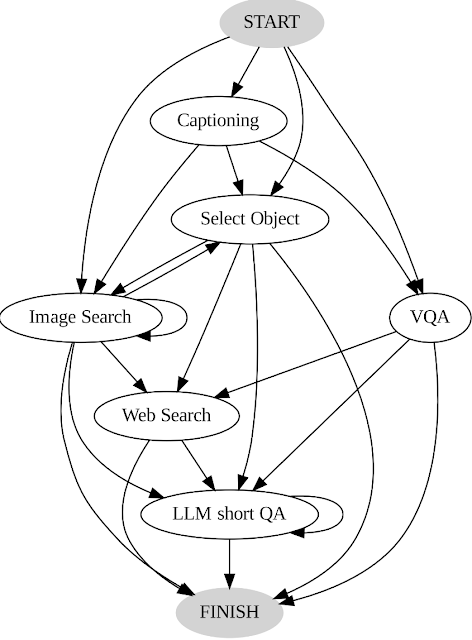

我们记录用户操作和输出,并以两种关键方式将其用作我们系统的指南。首先,我们通过分析用户做出的决策顺序来构建一个过渡图(如下所示)。此图定义不同的状态,并限制每个状态的可用操作集。例如,在启动状态下,系统只能执行以下三个操作之一:PALI 标题、PALI VQA 或对象检测。其次,我们使用人类决策的例子来指导我们的计划者和推理者与相关的上下文实例,以提高我们系统的性能和有效性。

|

| AVIS过渡图。 |

A. 总体框架

我们的方法采用动态决策策略,旨在响应视觉信息搜索查询。我们的系统有三个主要组成部分。首先,我们有一个计划器来确定后续操作,包括适当的 API 调用和它需要处理的查询。其次,我们有一个工作内存,它保留了有关从 API 执行中获得的结果的信息。最后,我们有一个推理器,其作用是处理 API 调用的输出。它确定获得的信息是否足以产生最终响应,或者是否需要额外的数据检索。

每次需要决定使用哪种工具以及向其发送什么查询时,计划人员都会执行一系列步骤。根据当前状态,规划者提供一系列潜在的后续操作。潜在的操作空间可能太大,以至于搜索空间难以处理。为了解决这个问题,计划者参考了过渡图来消除不相关的操作。计划器还排除了之前已经采取并存储在工作记忆中的操作。

接下来,规划者收集一组相关的上下文示例,这些示例是根据人类在用户研究期间先前做出的决策组装而成的。通过这些示例和保存从过去工具交互中收集的数据的工作记忆,计划人员制定提示。然后将提示发送到LLM,LLM返回结构化答案,确定要激活的下一个工具以及要向其发送的查询。这种设计允许在整个过程中多次调用计划器,从而促进动态决策,逐渐导致回答输入查询。

我们聘请推理器来分析工具执行的输出,提取有用的信息,并确定工具输出属于哪个类别:信息性、无信息性或最终答案。我们的方法利用LLM和适当的提示和上下文示例来执行推理。如果推理者得出结论,它已准备好提供答案,它将输出最终响应,从而完成任务。如果它确定工具输出没有信息,它将返回到计划程序以根据当前状态选择另一个操作。如果它发现工具输出有用,它将修改状态并将控制权转移回计划员,以便在新状态下做出新决策。

|

| AVIS 采用动态决策策略来响应视觉信息搜索查询。 |

结果

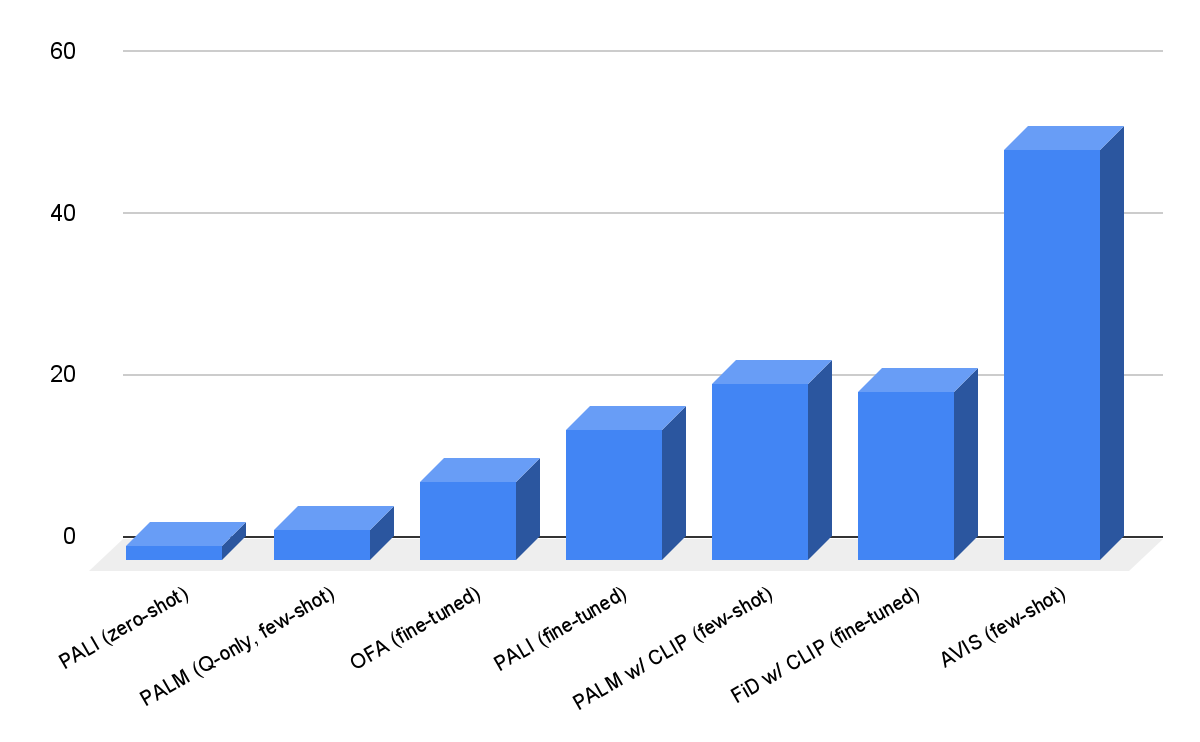

我们评估 AVIS信息搜索和OK-VQA数据。如下所示,即使是健壮的视觉语言模型,例如奥法和巴利语,在 Infoseek 上进行微调时无法产生高精度。我们的方法(AVIS)无需微调,在该数据集的看不见的实体拆分上实现了50.7%的准确率。

|

| Infoseek 数据集上的 AVIS 视觉问答结果。与基于以下的先前基线相比,AVIS 实现了更高的精度巴利语,手掌和奥法. |

我们在OK-VQA数据集上的结果如下所示。AVIS在上下文中的例子很少,准确率达到60.2%,高于以前的大多数作品。与在OK-VQA上微调的PALI模型相比,AVIS实现了较低但相当的精度。与 AVIS 优于微调 PALI 的 Infoseek 相比,这种差异是由于 OK-VQA 中的大多数问答示例依赖于常识知识而不是细粒度知识。因此,PaLI 能够在模型参数中编码此类通用知识,并且不需要外部知识。

|

| A-OKVQA 上的可视问答结果。与以前使用少镜头或零镜头学习的工作相比,AVIS 实现了更高的准确性,包括火烈鸟,巴利语和毒蛇.AVIS还比之前在OK-VQA数据集上微调的大多数工作实现了更高的精度,包括揭示,恢复,凯特和克里斯普,并实现接近微调的结果巴利语型。 |

结论

我们提出了一种新颖的方法,使LLM能够使用各种工具来回答知识密集型视觉问题。我们的方法基于从用户研究中收集的人类决策数据,采用结构化框架,该框架使用LLM驱动的规划器来动态决定工具选择和查询形成。LLM 驱动的推理器的任务是从所选工具的输出中处理和提取关键信息。我们的方法反复使用计划者和推理者来利用不同的工具,直到收集到回答视觉问题所需的所有必要信息。

确认

这项研究由Ziniu Hu,Ahmet Iscen,Chen Sun,Kai-Wei Chang,Yizhou Sun,David A. Ross,Cordelia Schmid和Alireza Fathi进行。