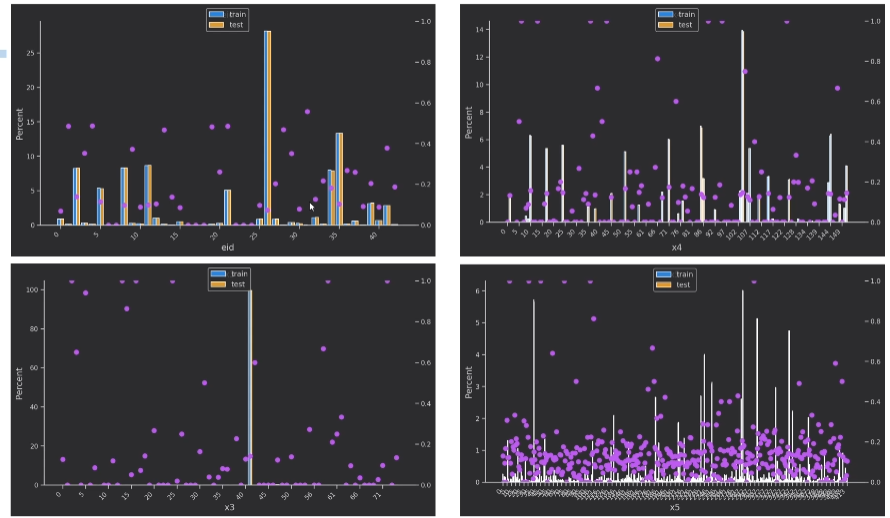

1. 可视化相关:

2. 交叉验证:(提分技巧之一)

k折交叉验证 k-fold cross validation

首先随机地将数据集切分为 k 个互不相交的大小相同的子集;

然后将 k-1 个子集当成训练集训练模型,剩下的 (held out) 一个子集当测试集测试模型;

将上一步对可能的 k 种选择重复进行 (每次挑一个不同的子集做测试集);

这样就训练了 k 个模型,每个模型都在相应的测试集上计算测试误差,得到了 k 个测试误差,对这 k 次的测试误差取平均便得到一个交叉验证误差。这便是交叉验证的过程。

计算平均测试误差 (交叉验证误差) 来评估当前参数下的模型性能。

在模型选择时,假设模型有许多 tuning parameter 可供调参,一组 tuning parameter 便确定一个模型,计算其交叉验证误差,最后选择使得交叉验证误差最小的那一组 tuning parameter。这便是模型选择过程。

k 一般大于等于2,实际操作时一般从3开始取,只有在原始数据集样本数量小的时候才会尝试取2。

k折交叉验证可以有效的避免过拟合以及欠拟合状态的发生,最后得到的结果也比较具有说服性。

k折交叉验证最大的优点:

• 所有数据都会参与到训练和预测中,有效避免过拟合,充分体现了交叉的思想

交叉验证可能存在 bias 或者 variance。如果我们提高切分的数量 k,variance 会上升但 bias 可能会下降。相反得,如果降低 k,bias 可能会上升但 variance 会下降。bias-variance tradeoff 是一个有趣的问题,我们希望模型的 bias 和 variance 都很低,但有时候做不到,只好权衡利弊,选取他们二者的平衡点。

通常使用10折交叉验证,当然这也取决于训练数据的样本数量。

3. 模型集成:voting